Inkscape: Grafische Editoren, Beschreibungssprachen und ihre Tücken

Anfang bis Mitte der 90er habe ich ja sehr ausgiebig den freien Raytracer POV-Ray genutzt. Auch wenn ich mich immer wieder mal an Moray gewagt habe – mit 3D-Modellierern wurde ich nicht wirklich warm. Die Szenenbeschreibungssprache (SDL, scene description language) von POV-Ray wiederum lag mir sehr. Und es hat mir auch wunderbar dabei geholfen, boolesche Operationen auf Mengen (Vereinigung, Differenz, Schnittmenge usw.) sowie Vektorrechnung zu verstehen. Grundsätzlich war die SDL hervorragend geeignet zur Beschreibung dreidimensionaler Szenen.

Eine Kugel wurde da bspw. als Menge aller Punkte definiert, die einen Abstand r von einem Punkt z haben. Damit war eine Kugel wirklich eine Kugel und keine Menge an Dreiecken, die nur in Annäherung eine Kugel ergeben.

Wenn ich eine Differenz zwischen der Kugel und einer Ebene durch den Mittelpunkt der Kugel bildete, bekam ich eine Halbkugel. Ebenso bei der Schnittmenge in diesem Fall, dann jedoch die andere Halbkugel.

Es hat sich in vielerlei Hinsicht als sinnvoll erwiesen, die Objekte im Ursprung zu entwerfen und erst am Ende zu skalieren und zu translatieren (bewegen). Eine Kugel, die bei <0,0,0> definiert ist, verhält sich nämlich anders als eine Kugel, die bei <1,0,0> definiert ist. Skaliere ich beide Kugeln um 2, bleibt erstere mit ihrem Mittelpunkt an Ort und Stelle, letztere bewegt sich um den Skalierungsfaktor entlang der x-Achse, da all ihre Punkte um den Faktor skaliert werden. Und Translationen finden dann ganz zum Schluss statt, wenn das Objekt die passende Größe hat, denn eine Skalierung am Ende würde auch die Translation skalieren.

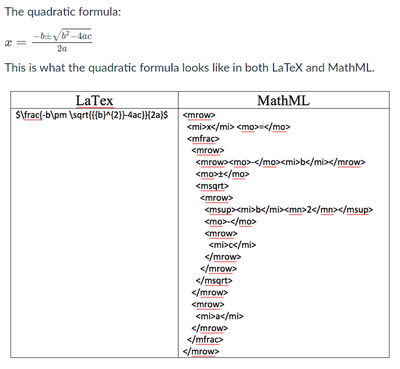

SVG wiederum ist XML. XML ist eine Auszeichnungssprache. Das heißt grob, dass mit XML irgendwelche menschenlesbaren Texte oder Werte ausgezeichnet werden, damit sie maschinenlesbar und -interpretierbar sind. Schon MathML zur Auszeichnung mathematischer Ausdrücke hat mich in seiner Unleserlichkeit schockiert, SVG ist nur graduell besser. Beide Sprachen kranken meiner Meinung nach daran, dass sie den Gegenstand des Interesses (mathematische Ausdrücke einerseits, 2D-Vektorgrafik andererseits) krampfhaft in XML verpacken wollten. Aber jut, so isses halt. Vermutlich ging es darum, mittels CSS und JavaScript auf die jeweiligen Dokumente zugreifen zu können, und das DOM existierte ja schon für (X)HTML. Ich habe aber auch nur sehr wenige MathML- und SVG-Inhalte im Web gesehen und noch weniger dynamisch mit JavaScript manipulierte. Wobei das ziemlich cool wäre. Aber ich vermute HTML5's canvas-Element hat SVG hier überflüssig gemacht

Was mich aber fuchst, ist die primitive Form der booleschen Operationen: Wenn ich einen Kreis mit einem Rechteck vereinige, dann werden beide Formen zu einem Pfad. Ihre ursprüngliche Natur geht dabei verloren und sie lassen sich auch nicht mehr ohne weiteres trennen oder auch nur in ihren Parametern verändern, es sei denn ich bearbeite die Knoten des Pfades manuell.

Eine andere Sache ist das Koordinatensystem. Zumindest bei Pfaden gibt es sowohl absolute als auch relative Angaben. Und Inkscape nutzt dynamisch, was gerade opportun ist: Ist der Pfad am Ursprung <0,0> definiert, sind es absolute, ansonsten zumeist relative Werte. Aber eben auch nicht immer. Manchmal wechselt Inkscape da auch einfach innerhalb eines Pfades. Tatsächlich kann ich keinerlei Grund für die Existenz absoluter Werte erkennen außer für den Startpunkt.

Ein Workaround wäre es vielleicht, alle Objekte in eine (eigene) Gruppe zu stecken. Denn gruppierte Objekte werden nicht mehr weiter angefasst bei Transformationen. Stattdessen erhält das Gruppenobjekt alle Transformationen wie Skalierungen und Translationen. Denn natürlich gibt es mehr als einen Weg, Objekten ihren endgültigen Ort zuzuweisen.

Eine zusätzliche Herausforderung sind die Farb-Definitionen (hier mal als Sammelbegriff für alles, was mit Konturfarben und Füllfarben zu tun hat). Ich weiß nicht, ob SVG das so erfordert, aber Inkscape macht es so: Alle komplexeren Farbinformationen wie Farbverläufe oder Filter werden nur im style-Attribut referenziert. Ihre tatsächliche Definition liegt in einem speziellen defs-Element. Und natürlich haben Verläufe absolute statt objekt-relativer Koordinaten. Wenn ich also programmatisch ein Element irgendwo hinsetze, dann muss ich auch seine referenzierten Definitionen entsprechend transformieren.

Die Probleme, die ich mit SVG habe (und ich bin eigentlich ein SVG-Fan, seit ich erstmals von SVG gehört habe), beruhen teilweise auf dem Format, teilweise auf Inkscape, was ich zur Erstellung nutze. Um SVG sinnvoll in einem programmatischen Kontext nutzen zu können, müssen allen Elementen id-Attribute zugewiesen werden, aber Inkscape erzeugt die für viele Elemente automatisch und erlaubt nur bei einer Teilmenge die manuelle Änderung der id. Aus einer Usability-Perspektive kann ich das nachvollziehen, zwingt mich jetzt aber dazu, entweder das erzeugte SVG komplett zu überarbeiten oder aber mir SVG-Fragmente aus meinem SVG zu nehmen und sie programmatisch erneut zu erzeugen, aber mit selbst definierten id-Attributen.

Und letzteres mache ich gerade für das D&D-Overlay. Vorbereitend erstelle ich das Gerüst nochmal sauber mit am Ursprung verankerten Koordinaten, ebenso alle Teilstücke. Dann entnehme ich die Teilstücke der SVG-Datei und füge sie in ein Pythonskript und vergebe id's vom Format "rangNzauberplatzM" als Präfix vor den drei Kreisen, aus denen die "Kugeln" bestehen. Am Ende ist das hoffentlich nur noch ein großes Puzzle, das ich wieder zusammensetzen muss. Wenn die Elemente und ihre referenzierten Definitionen alle am Ursprung entworfen sind, kann ich mittels einer abschließenden Transformation alles dorthin setzen, wo ich es brauche. Inkscape unterstützt solch einen Workflow leider nur mäßig. Andererseits kann ich mich ja auch dazu zwingen, alles einzeln in Inkscape zu entwerfen und erst am Ende zusammenzusetzen, wie ich es ja auch gerade tue.

Meine Erfahrungen mit Microsoft 365

Ich arbeite jetzt ja seit fast einem Jahr mit Microsoft 365 (alt: Office 365). Davor durfte ich bei Wikimedia Deutschland mit der G Suite (alt: Google Apps) arbeiten.

Ich bin ja durchaus ein Freund von Desktop-Clients, aber die Microsoft-Produkte haben mich das letzte Mal so um 2005 herum beeindruckt. Danach fiel es mir echt schwer, den Mehrwert für Microsoft Office zu erkennen. Es mag Einzelfälle geben, aber auf die stoße ich nicht.

Das Refaktorisieren und Reformatieren großer Textdokumente mache ich 1000 Mal lieber in Writer als in Word. Fairerweise gebe ich zu, dass Word die Anzeige benutzter Formatierungen besser gelöst hat. Aber wenn ich sowieso nur mit Formatvorlagen arbeite, brauche ich das auch nicht. Das lohnt sich spätestens dann, wenn ich beschließe, dass bestimmte Textabschnitte doch nicht mit der einen, sondern mit der anderen Schriftart setzen will.

Aber das war gar nicht die Auslöserin dieses Beitrags, sondern Outlook. Der Vergleich wird jetzt unfair. Während meiner Arbeit mit der G Suite habe ich lieber mit Thunderbird als mit der Gmail-Web-Anwendung gearbeitet, aber wenn ich etwas in meinen Mails gesucht habe, bin ich doch oft zu Gmail gegangen. Denn wenn Google eine Sache gut kann, dann suchen. Mittlerweile weiß ich auch, dass ich all meine Suchen auch in Thunderbird hätte ordentlich durchführen können (Schnellsuche ist nicht Suche ist nicht erweiterte Suche, und letztere habe ich nicht wahrgenommen, weil mittlere den Eindruck erweckte, das Beste in Sachen Suche bei Thunderbird zu sein). Aber was Outlook hier abliefert, ist einfach nur peinlich.

Will ich in Thunderbird alle ungelesenen E-Mails anzeigen lassen, dann klicke ich einfach "ungelesen" in der Schnellsuche an. Und schwupps werden mir in der Nachrichtenliste nur die ungelesenen Nachrichten angezeigt. Bei Outlook vermute ich hinter "Filter" eigentlich eine ähnliche Funktion. Wähle ich dort jedoch "ungelesen" aus, werden mir nicht meine 6 ungelesenen Nachrichten angezeigt, von denen ich die Hälfte sogar noch in der ungefilterten Ansicht sehen kann, sondern: gar keine!

Nach einem Neustart von Outlook funktioniert es dann aber doch. Sorry, aber das ist einfach nur Müll.

Über die Unterschiede von Microsoft 365 und der G Suite werde ich ein anderes Mal schreiben. So viel vorweg: Der einzige Grund für Microsoft 365 dürften die Office-Lizenzen sein.

Und damit mir nicht unterstellt wird, ich würde ja Microsoft nur hassen: Visio ist super. Ich habe noch nichts Vergleichbares finden können. Jedes Mal, wenn ich Diagramm machen will, denke ich wehmütig an meine Arbeit mit Visio zurück. Glücklicherweise sind Diagramme bei mir nicht an der Tagesordnung.

Mediale Teilhabe

Ich erinnere mich, in der Anfangszeit des Webs nutzten meine Freund*innen und ich intensiv E-Mail, um uns gegenseitig aufmerksam zu machen auf interessante Artikel und Links. Jede*r von uns hatte andere Interessen, Schwerpunkte und Aufmerksamkeiten, so dass der E-Mail-Verteiler mit einem bunten Mix an an lustigen, spannenden, nachdenklichen, empörenden Links gefüllt war.

Das war noch vor der ersten Dotcom-Blase. RSS-Feeds waren gerade erst erfunden und der breiten Masse noch nicht bekannt (heute hingegen sind sie der breiten Masse nicht mehr bekannt. Der breiten Masse waren sie ungefähr am 29. Februar 2010 bekannt). Viele Medien im Web waren genuine Web-Medien, ohne große Historie in der physischen Welt. Blogs hießen noch Weblogs und wurden in Nepal in Handarbeit hergestellt. Wikis waren abgekürzte Wikinger. Es war die gute alte Zeit.

Mit der Zeit drängten immer mehr Medien ins Netz. Immer mehr Leute kamen auf die Idee, Geschäftskonzepte mit Web-Inhalten zu verbinden. Ehrlich: Ich habe keine Ahnung, wie Internetcompanys in den Nuller-Jahren ihr Geld verdient haben, wenn sie nicht Amazon oder Ebay hießen. Facebook und Twitter hatten beide kein Konzept, aber die Investoren überschütteten sie mit Geld.

Ich pflegte meine Sammlung an RSS-Feeds. Ich hatte für den Desktop RSS-Reader, deren Namen ich längst vergessen habe, Liferea[1] oder Feedreader[1]. Und so wäre es vermutlich weiter gegangen, hätte nicht das mobile Internet dank Apples iPhone eingesetzt, denn auf einmal wollte ich auch mobil meine Feeds lesen. Für Palms Pre gab es den Tea-Reader[#RSS], derr gut mit dem Google Reader klarkam. Ich zog meine RSS-Feed-Sammlung zum Google Reader um, der dann aber Google Plänen zur Weltherrschaft vermittels Google+ zum Opfer fiel. Aber für einige Zeit konnte ich meine Feeds an verschiedenen Geräten lesen, der Lesestatus wurde dank Google Reader auf allen Geräten synchron gehalten. Vorher hatte ich mitunter 300 ungelesene Einträge auf meinem Desktop, die ich alle schon am Laptop gelesen hatte (als gelesen markiert, natürlich; ich lese ja nur den Teil, wo Titel und Anrisstext interessant klingen).

Google hob Google+ aus der Taufe, weil Facebook die Aufmerksamkeit seiner Nutzer*innen länger und häufiger binden konnte als Google. Google brauchte aber auch diese knappe Ressource, denn damit machen sie Geld. Für Facebook optimiert gab es dann Inhalte von Firmen, deren einziger Zweck es war, die Aufmerksamkeit der Nutzer*innen einzufangen, Buzzfeed, HuffPost und zahlreiche andere. Immer mehr Aufmerksamkeit fiel unter die Ägide vom Gatekeeper Facebook (und im geringeren Maße Twitter). Immer mehr Inhaltslieferanten boten ihre Inhalte auf Facebook feil, im steten Kampf um die Aufmerksamkeit der Nutzer*innen.

Ich habe mit der Einstellung des Google Readers meine RSS-Feed-Sammlung erst zu Feedly verschoben (lief gut), dann aber beschlossen, Tiny Tiny RSS selbst zu hosten (der Entwickler ist anstrengend, arrogant und teilweise geschichtsvergessen, aber die Software tut, was sie soll). Ich nehme gelegentlich Änderungen an der Zusammenstellung meiner Feeds vor, aber ich habe ansonsten eine relativ stabile Quelle an Quellen.

Angefeuert von der Aufmerksamkeitsökonomie in den sozialen Netzwerken verfielen immer mehr Anbieter auf kleine Informationshäppchen. Sicher spielte auch die Schwierigkeit der Monetarisierung von einzelnen Inhalten eine Rolle, im Endeffekt war es aber das gleiche: Viele kleine Beiträge, die möglichst hohe Reichweite erreichen mussten. Meine RSS-Feeds wurden voller und voller, die Abarbeitung der ungelesenen Beiträge wurde tatsächlich Arbeit von mehreren Stunden täglich. In den sozialen Netzwerken hingegen wird algorithmisch gesteuert die Aufmerksamkeit der Nutzer*innen so weit wie möglich angezapft mit Beiträgen, die ein höchstmögliches Potential an engagement besitzen, also der Eigenschaft, die Leser*innen zur Interaktion mit der Plattform zu bewegen. Bestimmt sitzen in den Firmen hochbezahlte und studierte Fachkräfte, die ganz eigene dafür Metriken haben.

Für die breite Masse aber war der algorithmisch gesteuerte Zugang ein Segen, erlaubte er es ihnen doch, an Nachrichten[2] zu kommen, die sie sonst nie erreicht hätten. Und natürlich wurde munter geteilt, was einen am meisten bewegt hat. Skandale, tatsächliche und erfundene, sind dafür hervorragend geeignet. Und in der algorithmisch befeuerten Newsfeed-Welt gibt es ständig Futter für Skandalsucht.

Ich denke, da draußen gibt es gar nicht wenige Menschen, die sich schon von Jugend an aus dem frei verfügbaren Nachrichtenangebot ausgeklinkt haben, da sie ihre Informationen aus ihrem persönlichen sozialen, digitalen Umfeld beziehen, ohne Chance auf ein Korrektiv, weil Korrektive nicht emotionalisieren, sondern moderieren, aber Mäßigung fühlt sich halt ein bisschen an wie Tod, während Emotion sich wie Leben anfühlt. Sie befinden sich in Kreisen, deren Quellen algorithmisch zusammengestellt sind auf Basis von Automatismen, die nicht breite Information zum Ziel haben, sondern Bindung an die Plattformen. Es war nur folgerichtig, dass Facebook WhatsApp gekauft hat, denn die Dynamik zwischen algorithmischen Newsfeed bei Facebook und persönlicher Empfehlung via Messenger wird Facebook nicht entgangen sein.

Meine mediale Teilhabe ist eine, der darauf beruht, dass ich das technische Wissen habe, um mir meine Infrastruktur aufrechtzuerhalten. Das ist kein Modell für die Masse. Ein Modell wäre der tägliche Besuch vereinzelter Medienangebote, also das digitale Äquivalent zum Blättern in der Tageszeitung, aber dabei sollte man im Hinterkopf behalten, dass die Bild über Jahrzehnte die auflagenstärkste Tageszeitung war. Dass ihre Auflage rückgängig ist, liegt nicht daran, dass die Ansprüche der Leser*innen gewachsen sind, sondern dass der Bild Konkurrenz im Web erwachsen ist, der sie nicht gewachsen ist. Facebook, und später auch Twitter, haben sich vom Konzept ungefilterter Newsfeeds verabschiedet, aber sie stellen das Modell dar, das den größten Erfolg hat. Es ist niedrigschwellig genug, dass auch ohne Technikkompetenz medial teilgehabt werden kann.

Ich bin sicher, mein Gedankenfluss hatte so manchen Sprung, manches hätte mehr Ausarbeitung verdient, aber ich bin es erst einmal los. Danke für die Aufmerksamkeit.

ufw: unnecessary firewall

Ach!, Canonical!

Die Leutchen von Big Blue Button haben sich auf Ubuntu als Grundlage ihrer Software entschieden. Das ist ihr gutes Recht, auch wenn ich anders entschieden hätte. Leider machen sie aber auch Gebrauch von Canonicals Eigenentwicklung, der ufw, der uncomplicated firewall. Die ufw ist nicht wirklich eine Firewall, sondern vielmehr ein Frontend für iptables und ip6tables. Und ich hätte es auch nicht Frontend, sondern eher Wrapper genannt, aber die Unterschiede sind wohl eher marginal.

Tatsächlich nutzt ufw im Hintergrund ip(6)tables, um ihre Regeln umzusetzen. Dummerweise scheint sich der uncomplicated-Teil des Namens auch nur auf unkomplizierte Umgebungen zu beziehen. Schon Containern Zugriff auf das Internet zu gewähren, erfordert es ein tieferes Verständnis von der ufw zu erlangen. Und wenn die Container untereinander sprechen können sollen, dann scheint es ohne Kenntnis von iptables schon gar nicht mehr zu gehen.

iptables sind nicht schön. Sie sind geradezu hässlich. Und ich werde drei Kreuze machen, wenn nftables oder bpfilter iptables ersetzen. Aber noch hässlicher als iptables ist das Zusammenspiel von ufw + iptables. Ich sehe keinen Gewinn für den angehenden Admin, sich mit zwei sehr unterschiedlichen Syntaxen auseinanderzusetzen, wenn sich auch mit einer alles erreichen lässt, zumal dann keine Kenntnis über irgendwelche impliziten Maßnahmen der ufw notwendig sind. ufw hat wirklich nur dort einen Existenzgrund, wo so simple Konstellationen auftreten, dass sie auch mit wenigen iptables-Befehlen umzusetzen wären.

Ich bin jedenfalls kurz davor, die ufw zu deaktivieren und komplett auf iptables zu setzen.

Big Blue Button, ufw und container

Since a few weeks, I rented a server for running Big Blue Button. Besides Jitsi Meet, Big Blue Button is one of the most feature rich free software video conferencing solutions.

Also, Big Blue Button is a bolted mess of many components running barely in any other environment than the one the developers intended. Actually, it's barely running. 🙂

To be fair, there are a lot of components involved. And there aren't many developers having the necessary insights, so progress is slow. Until a few weeks ago BBB had to be run on Ubuntu 16.04 Xenial, but they now have their install script adapted to Ubuntu 18.04 Bionic. Well, we are in 2021 already and a lot of people expect to be able to install BBB on Ubuntu 20.04 Focal. But as I said, progress is slow.

As there are many components, the team strongly recommends to firewall the server. Everyone does that, doesn't they, mh? Well, they decided to use ufw for that. That wouldn't be a problem if I didn't have the idea to setup some additional containers on the machine to make it a little bit more useful.

When mentioning containers almost everyone thinks of docker containers but there are at least two more technologies available on Linux. The aptly named lxc (Linux Containers) and systemd's approach nspawn. As the whole world uses docker and one of my favourite (ex) colleagues prefers lxc I decided to have some fun with nspawn. But I guess many of the problems I had would also appear with lxc or docker.

Actually, BBB makes use of some docker containers so that might have increased my problems but I'm not sure about that as no solution or workaround needed touching their config. I guess, their presence just made my problems seem more complex than they actually were.

The symptoms I observed were simple: My containers didn't get any IP. They had no network connectivity.

The main culprit of course was ufw. BBB's default firewall rules only allow ssh, http, https and a range of ports needed for WebRTC. ufw blocked all traffic from the containers, including DHCP. So I needed to allow DHCP. I wrote an application profile for that but that's mostly unnecessary as we only need to open TCP ports 67 and 68.

ufw allow 67:68/tcp

And my containers got their IP addresses!

But they still couldn't do anything. Okay, I could ping other IP addresses.

ping 8.8.8.8

Call me spoiled, but I'd expect ICMP to be blocked if default policy is to reject. But hey, I was thankful to see that something works at least. But name resolution didn't work. Allowing port 53 analoguosly didn't help. I could tcpdump my packets not reaching the bridge interface. The solution was to allow forwarding packets to this port:

ufw route allow 53

And now, name resolution worked. I left out the steps inbetween (I changed the default forward policy and reset it afterwards). That means I could ping by providing a hostname. Progress! But I couldn't curl. Not only because I had to install the curl package but also because the only open ports for my containers were … let me count … oh, port 53.

ufw route allow 80,443/tcp

And now I can curl.

Of course, there's room for improvement. I could limit the rules to my container subnet or even to single containers. But this last idea is doomed to fail because of DHCP. So I could still limit the forwarding rules to my subnet. As they are only valid for forwarding and I want to forward only to my containers there doesn't seem to any benefit in adding more complexity.

I guess I got all the search terms into this entry I tried while searching for a solution to my problem without getting any concrete results. Maybe someone in the same situation as me might find this helpful.

Error: Assertion failed for PostgreSQL Cluster

If you ever encounter this error message

Assertion failed for PostgreSQL Cluster cluster-name

or

Assertion failed on job for postgresql@11-cluster-name.service

after creating a cluster of the name "cluster-name" it might be because somewhere the hyphen is considered invalid. Just

pg_dropcluster <version> cluster-name pg_createcluster <version> clustername

to drop and re-create the cluster without hyphen.

I created this blog entry because I could not find any reference to this specific error with this specific reason. It might be some Debian specific error as PostgreSQLs initdb command is wrapped by pg_createcluster which again isn't mentioned by PostgreSQL. Searching the web shows mostly results in context of Ubuntu and Debian.

Wissenschaftliche Propaganda

Ich gebe es offen zu: Ich bin wissenschaftlicher Propagandist.

Zum Journalisten, insbesondere Wissenschaftsjournalisten tauge ich nicht. Aber ich verbreite gerne deren Werke, ich propagiere sie. Ich selbst bin wissbegierig, neugierig und zumindest in Ansätzen wissenschaftlich literat. Würde ich ein paar Jahrhundert in die Vergangenheit versetzt werden, ich könnte vielleicht als Universalgelehrter herhalten.

Aber das Lesen könnte ich ja auch allein und im stillen Kämmerlein machen und euch alle unbehelligt lassen. Aber das will ich nicht, weil ich denke, dass eine breitere Kenntnis über das, was in der Wissenschaft so vor sich geht, für die Gesellschaft als ganzes gut ist. Ich mag in nicht wenigen Situation oberlehrerhaft rüberkommen, aber ich kann euch versichern, dass mir die didaktische Ausbildung zum Lehrer fehlt. Nein, vielmehr möchte ich meine Freude an Wissen und Wissenschaft teilen. Ich habe da ganz klar meine Vorlieben – Meere und Meereslebewesen interessieren mich jetzt nicht so dolle. Weltall und Physik liegen weit vorne. Dicht dahinter kommen Medizin und Chemie. Biologie ist ein wenig abgeschlagen. Geschichte ist problematisch, da sie stark Interpretationen unterworfen ist – harte Fakten sind eher die Ausnahme denn die Regel. Das gleiche mit Politik.

Ich freue mich über Menschen, die mich mit Beiträgen aus ihren eigenen Interessensgebieten versorgen, die eine Vorauswahl treffen und das dann in die sozialen Medien bringen. Noch mehr freue ich mich über diejenigen in den sozialen Medien, die zu schätzen wissen, was ich so teile.

Es ist nicht nur persönliche Bestätigung, auch wenn ich ihre Wirkung durchaus zu schätzen weiß. Denn mehr noch befriedigt mich der Gedanke, dass ich die Welt ein kleines bisschen besser mache mit jeder und jedem, die oder der die von mir geteilten Beiträge liest und ein klein wenig daraus mitnimmt. Ich bin der festen Überzeugung, dass wir als Gesellschaft, als Menschehit, als Gemeinschaft nur weiterkommen, schaffen wir ein Umfeld, in dem wissenschaftliche Erkenntnisse möglichst weite Verbreitung haben. Damit einzelne Menschen herausragende Leistungen vollbringen können, müssen sie gestützt werden von einem Sockel an wissenschaftlicher Offenheit und Belesenheit.

Daher rühren auch andere meiner Positionen: Ich bin kein Freund von Gymnasien, denn auch wenn die Schülerinnen und Schüler dort vielleicht Spitzenabschlüsse erlangen können, schaffen Gymnasien eben keine breite, wissenschaftliche Bildung, da den Schülerinnen und Schülern der anderen Schulzweige der Kontakt zu den Top-Performern fehlt. Ich wage die Behauptung, dass Top-Performer in einem Umfeld mit solidem wissenschaftlichen Sockel mehr leisten könnten, als diejenigen, die noch bessere Abschlüsse erreichen könnten, aber in einem Umfeld weitgehenden Wissenschaftsanalphabetismus arbeiten müssen. Aus dem gleichen Grund halte ich wenig von sogenannten Elite-Universitäten oder Leuchtturmprojekten. Aber ich vermute, solange schon bei den Schulen eine Vorauswahl getroffen wird, ist Kritik an Elite-Einrichtungen witzlos.

Ich mag freies Wissen. Projekte wie die Wikipedia haben vermutlich mehr beigetragen zur Allgemeinbildung als alle Volkshochschulen zusammen. Auch deswegen finde ich, dass viele Gesetze mehr Rücksicht nehmen sollten auf unsere mentale, kulturelle und akademische Allmende.

Wissenschaft und Wissenschaftsjournalismus vermittelt aber auch, wie wunderbar und vielseitig unsere Welt ist, und damit meine ich nicht nur unsere Welt, sondern alles, das Weltall. Ich weiß, dass Menschen spirituelle Bedürfnisse haben (ich sicher auch), und ich finde, es gibt vieles zu entdecken, was auch von spirituellem Wert ist. Dafür braucht es kein Gedankengebäude von fragwürdiger Kohärenz, geschaffen von Menschen, die auf einen deutlich beschränkteren Fundus an Wissen zurückgreifen konnten. Der ständige Prozess des Zweifelns und der neuen Erkenntnis macht bescheiden und demütig – die Sicherheit von heute kann morgen schon widerlegt sein, Wahrheiten gibt es immer nur für den Augenblick. Ich kann auch nachvollziehen, dass Menschen mit Sicherheitsbedürfnis von der wissenschaftlichen Methode eher abgeschreckt sind. Aber ich sehe es als Vorteil: Die Welt ist zu komplex, um sie mit einfachen und statischen Erklärungen begreifen zu können. Wenn wir das akzeptieren lernen, wenn wir das zu leben lernen, reifen wir als Gemeinschaft.

Preisbildung: Angebot und Nachfrage

Tim Urban hat auf Wait But Why letztes Jahr eine sehr umfängliche Artikelserie gestartet zum Thema "politischer Diskurs". Heute habe ich endlich Teil 9 beendet (erschienen Dezember 2019) und Teil 10 begonnen (erschienen Januar 2020). Solange gammelte der Tab von Teil 9 im Firefox meines Tablets vor sich hin.

Teil 10 hat einen Abschnitt zum Thema "Polarisierung der Parteien", wo unter anderem das Kriterium "Most corporations make a fair and reasonable amount of profit" (etwa "die meisten Firmen erzielen einen gerechten und vernünftigen Profit") zur Unterscheidung zwischen "rechts" und "links" im politischen Spektrum herangezogen wird. Abgesehen davon, dass ich das Kriterium erst "andersherum" verstand –machen die Firmen genug Profit, um überleben zu können–, juckte mich die Attribuierung "fair" und "vernünftig".

Profit ist ja vereinfacht erstmal der Teil, der nach Abzug aller Kosten und Abgaben übrigbleibt. Es ist schwierig in verständliche Worte zu fassen, was das für eine Firma bedeutet, da Firmen ja unterschiedliche Rechtsformen haben können, aber simpel ausgedrückt, dürfte das mit dem Einkommen, Lohn, Gehalt vergleichbar sein, wäre die Firma eine Person (Konzept der juristischen Person mal außen vor gelassen), nur dass Miete, Lebensunterhalt und alles andere an diesem Punkt längst beglichen sind.

Mich interessieren hier nur die Firmen, die Produkte herstellen oder verkaufen und Dienstleistungen feilbieten, also jene Firmen, die Kunden haben, welche wiederum für Produkte oder Dienstleistungen zahlen.

In der Wirtschaft wird ja gerne von Angebot und Nachfrage schwadroniert, wenn es um die Preisbildung geht. Wird etwas stark nachgefragt, steigt der Preis bei gleichbleibendem Angebot, ebenso bei gleichbleibender Nachfrage und verringerndem Angebot.

Das beschert aber nur dann einen Profit, wenn die Ware zu einem Preis oberhalb ihrer Herstellungskosten verkauft werden kann.

Je billiger etwas in der Herstellung ist, desto geringer kann die Nachfrage sein, so dass sich ein Angebot lohnt. Der heilige Gral wäre dann ein Produkt, was umsonst hergestellt werden kann und jeder will und braucht. Sonnenlicht, Luft und Wasser fallen wohl in diese Kategorie (hey, Nestlé, ich weiß, was du vorhast).

Entsteht daraus aber ein Profit, der "fair" und "vernünftig" ist?

Aktuell gibt es ja so an die vier "Dinge", deren Preis öffentlich in Frage gestellt werden.

Der Apple Appstore

Epic ist der Meinung, dass die 30-Prozent-Abgabe an Apple für Verkäufe über den Appstore zu hoch sei. Ich finde online die Angabe, dass Apple 2019 mit dem Appstore 50 Milliarden umgesetzt habe, also 15 Milliarden an Apple flossen. Apple machte 2019 einen Gewinn ("gross profit") von knapp 100 Milliarden. Die Kosten für den Betrieb des Appstores kann ich leider nicht finden. Ich wage die Behauptung, dass es nicht mal 1 Milliarde ist, und darin dürften die Kosten für Server, Leitungen, Strom und Personal in Administration, Support und App-Prüfung bereits enthalten sein.

Wohnungsmieten

Nicht erst durch den Mietendeckel und dessen Vorgeschichte gerieten Mieten in die Kritik. Woraus setzt sich eigentlich ein Mietzins zusammen? Ein*e Vermieter*in hat natürlich Kosten für die Wohnungen zu tragen. Die Gebäude mussen in Schuss gehalten werden, sie müssen technisch und ökologisch gepflegt und aufgerüstet werden usw. Aber steigen diese Kosten in dem Maße wie die Anforderungen an die Wohnungen?

Traditionellerweise werden Wohnungsmieten anhand des Preisniveaus des Wohnumfelds festgesetzt. Vermutlich bin ich damit nicht alleine, aber es braucht wohl zumindest eine ansatzweise mathematische Begabung, um zu erkennen, dass diese Tradition eine Rückkopplung darstellt. Eine Miete wird erhöht, weil die Mieten im Wohnumfeld erhöht wurden. Da muss sich nichts an der Wohnungsausstattung geändert haben.

Gänzlich bizarr wird es, wenn der Staat verlangt, dass Vermieter*innen ihre Mieten anheben müssen, wie es mehrfach in München passiert ist.

Krankenversicherungen

Weniger in Deutschland (oder Europa) und mehr in den USA ein Thema, aber mit dem zweigleisigen System in Deutschland haben wir unser ureigenes Problem geschaffen. Ob es ein Problem ist, kann natürlich jede*r selbst für sich entscheiden – ich empfinde so.

Das Preisbildungsproblem jedoch sehe ich eher in den USA. Versicherungen werden von profitorientierten Firmen angeboten, die natürlich kein Interesse daran haben, ihre Ausgabenseite zu erhöhen, weswegen das Versichern von Menschen mit Vorerkrankungen prohibitiv teuer ist.

Arzneimittelkosten

Eng verwandt mit dem vorigen Punkt sind die Arzneimittelkosten. Sprichwörtlichen Nicht-Ruhm erlangten sie durch die "Apothekerpreise". Aber auch das Preisgefälle zwischen patentierten und generischen Medikamenten (ich weiß, es ist nicht der korrekte Gegensatz, aber hier passend) erregt immer wieder die Gemüter.

Was ist "fair", was ist "vernünftig"?

Es gibt sicher noch mehr aktuelle Beispiele. Ich könnte mich an Immaterialgütern wie Musik und Software abarbeiten, aber ich lasse das mal. Nur so viel: Näher an kostenlose Produktion kommt man wohl kaum als über Immaterialgüter.

Bezeichnend für die obigen Beispiele ist, dass der Preis nicht durch Angebot und Nachfrage gebildet wird, sondern durch die Eliminierung von Alternativen, mithin also dem Ausschalten von Wettbewerb.

Apple kann die 30 Prozent verlangen, weil es keinen anderen Weg auf deren Plattform gibt.

Günstigere Wohnungen in anderer Lage sind eben keine Alternative, weil man nicht die Wohnungsausstattung mietet, sondern die Wohnungsausstattung in konkreter Lage. Davon hängen so viele andere Aspekte ab, dass Menschen mitunter keine andere Wahl haben, als die höhere Miete zu zahlen. Wem die Mieten in München oder Berlin zu hoch sind, kann eben nicht einfach 150 Kilometer weiter weg ziehen – das soziale Umfeld, die Arbeit, die Infrastruktur ziehen alle nicht mit.

Ich gebe zu, Versicherungen sollten am ehesten noch in Wettbewerb miteinander treten, aber ich vermute, sie befinden sich in einem Gleichgewicht, wo sie das Maximum an Profit erwirtschaften können. "Kund*innen" haben praktisch keine Möglichkeit, zu einem Wettbewerber zu gehen, weil der gleichermaßen teuer ist. Hinzukommt, dass in den USA Versicherungen wohl oft an den Arbeitgeber gebunden sind. Vielleicht weiß jemand meiner Leser*innen mehr darüber.

Arzneimittel werden unter Monopolschutz verkauft. Das Patentsystem ist ja explizit dafür geschaffen worden, um Erfinder*innen einen Zeitraum zu bieten, wo sie ihre Erfindung ohne Wettbewerb anbieten können.

Können unter solchen Bedingungen Profite "fair" und "vernünftig" entstehen?

Was ist für mich "fairer" und "vernünftiger" Profit?

Erstmal erkenne ich an, dass Firmen Profit erwirtschaften wollen und müssen. Sie sollen ihre Produkte und Dienstleistungen nicht verschenken müssen.

"Vernünftig" ist für mich ein Profit, der ausreicht, um ihn in die Verbesserung der Wettbewerbsfähigkeit zu stecken. Das klingt natürlich toll, ist aber wischiwaschi. Was soll das denn bedeuten?

"Vernünftig" sind Profite, wenn sie das Überleben einer Firma auf einem Markt ermöglichen. "Fair" sind Profite, wenn sie Kund*innen wirtschaftliche oder emotionale Vorteile bringen. Auch das: viel zu unkonkret. Aber vielleicht ist die Richtung erkennbar.

"Fair" ist der Profit, der so klein ist, dass er gerade noch "vernünftig" ist. Es wird abstrakt. Aber immerhin kann ich jetzt eine Aussage treffen: Fairer Profit ist geringer als vernünftiger Profit. "Fair" spiegelt hierbei die Interessen der Kundschaft wider, während "vernünftig" die Interessen der Firma widerspiegelt. Jetzt kann ich es als Interessensausgleich betrachten. Es bringt mich einer Antwort noch nicht wirklich näher, aber emotional empfinde ich das beruhigender.

Idealerweise ist Profit also eine Aushandlung zwischen der Gesamtheit aller Kund*innen einer Firma und der Firma selbst. Kund*innen wollen so wenig wie möglich zahlen, Firmen so viel wie möglich einnehmen. Sie treffen sich kurz oberhalb des Punktes, wo die Firma sagt: "Nee, das lohnt sich für mich dann nicht". Es bleibt die Frage, ab welchem Profit "lohnt" es sich für eine Firma, ihr Produkt oder ihre Dienstleistung zu verkaufen?

Ich bin eine Firma, hypothetisch. Ich biete ein Produkt an, meine Arbeitskraft und mein Knowhow, also eigentlich eine Dienstleistung. Meine Kund*innen sind andere Personen oder Firmen. Meine Ausgaben zur Erbringung meiner Dienstleistung setzen sich zusammen aus Lebenshaltungskosten, Schuldendienst (Kredit für Haus) und Mobilität, grob gesagt. Andere würden den Schuldendienst durch Miete ersetzen.

Meine Kund*innen würden den Standpunkt vertreten, ich müsste ja nur obige Ausgaben mit meiner Dienstleistung erwirtschaften. Ich hingegen habe das Interesse, Geld für Konsum und Vergnügen zur Verfügung zu haben. Meine Kund*innen stimmen mit mir überein, also soll ich 60 Stunden pro Woche meine Dienste erbringen, dann blieben mir am Wochenende 24 Stunden, um meinem Vergnügen zu frönen und am Konsum teilzuhaben.

Komische Rechnung? Ja, denn ich impliziere, dass meine Kund*innen mein Zeit-, Konsum- und Vergnügungsbudget bestimmen. Und vor 100 Jahren, na, mittlerweile eher 150 Jahren waren solche Bestimmungen vermutlich noch alltäglich. Es gab einen gesellschaftlichen Konsens darüber, welches Maß an Konsum und Teilhabe an Vergnügungsmöglichkeiten akzeptabel ist. Mein Gedankengang mag sich im Text nicht vollständig wiederfinden; ich hoffe, meine Leser*innen können die Lücken selbständig schließen.

Worauf ich hinaus will: Was ein fairer und vernünftiger Profit ist, ist Ergebnis eines gesellschaftlichen Aushandlungsprozesses. Was darüber liegt, wird als Wucher und obszön empfunden. Unsere Wirtschaftswelt ist aber mittlerweile an einem Punkt angekommen, wo die Wahrnehmung von Preis, Preisbildung und Profit entkoppelt ist. Am ehesten erregt das wohl noch da, wo es die Lebensrealität am meisten berührt, den eigenen vier Wänden, wo Mieter*innen miterleben, wie sie Jahr für Jahr mehr zahlen müssen, obwohl sie keine Mehrleistung erhalten.

Der Beitrag dreht sich zwar nur um Profit und Preisbildung, aber Profitsteigerung ist unmittelbar ein Teil der Fragestellung. Wie weit kann ein*e Anbieter*in den Preis und damit den Profit steigern, bevor es zu einer Gegenbewegung kommt? Apple verspricht Sicherheit durch Prüfung, scheitert aber immer wieder damit. Zumal es kein Argument ist, alternative Bezugsquellen nicht zuzulassen. Sie könnten mit ihrem Sicherheitsversprechen ja in den Wettbewerb gehen. Stattdessen kämpft Apple um seine Gatekeeper-Rolle, damit ihr schönes, kleines und profitables Monopol erhalten bleibt. Vermieter*innen geben sich nicht mit dem steten Fluss an Mietzins zufrieden, sondern erwarten alljährliche Steigerungen. Und Jahrzehnte lang kamen sie damit durch, auch weil die Gehälter halbwegs im selben Maße stiegen (was natürlich auch die Ausgabenseite der Vermieter*innen beeinflusste, denn Handwerker*innen und Hausmeister*innen wollen auch bezahlt werden). Seit Mieter*innen aber nicht mehr mit regelmäßigen Gehaltssteigerungen zu rechnen haben, rücken die Ausgabensteigerungen durch Mieterhöhungen stärker in den Fokus: Welchen Mehrwert leisten die Vermieter*innen, um die Mieterhöhung zu rechtfertigen? Die Gehälter stagnieren weitgehend oder zumindest die Kaufkraft. Damit kann die höhere Miete nicht gerechtfertigt werden. Und ob Modernisierungen, die die Ausgabenseite der Vermieter*innen senken, von den Mieter*innen gestemmt werden müssen, fragen sich viele zurecht. Und welchen Wert hat ein Medikament, was jenseits der Grenze zu einem Bruchteil des hiesigen Preises offensichtlich immer noch profitabel verkauft wird? Es liegt sicher nicht daran, dass Medikament jenseits der Grenze im Überangebot steht oder weniger nachgefragt wird.

Anbieter*innen schauen natürlich, womit sie durchkommen können. Solange ihr Produkt oder ihre Dienstleistung –notfalls unter Murren– gekauft wird, können sie zufrieden sein. Deswegen gibt es aber auch immer wieder die Forderung, mit dem Portemonnaie abzustimmen, also manche Sachen gar nicht erst einzukaufen, solange die eine oder andere Geschäftspraktik nicht abgestellt wird. Das klappt aber nur in Märkten, wo die Bedürfnisse annähernd gleichwertig anderweitig befriedigt werden können. Der Wohnungsmarkt und der Arbeitsmarkt sind zwei Märkte, wo das nicht geht. Apple hat sich selbst einen Markt geschaffen, wo die Kund*innen das nicht können. Und das Gesundheitswesen im ganzen ist ebenfalls ein Markt, wo das nicht geht.

Mac-Hardware und Webcamvergleich

Eine Sache, die mir seit einigen Wochen im Kopf herumschwirrt: Apple und Hardware. Und Webcams, gerade die waren der Auslöser.

Apples Hardware wird ja viel gelobt, zehrt aber eher von dem Ruf, den sich Apple in den frühen 10er Jahren erworben hat. Ich habe in den vergangenen Jahren mehrfach schon den Kopf schütteln müssen, wie lausig teilweise die Qualität ist (Tastatur, Netzteil).

Auf der anderen Seite gibt es Komponenten, die herausragend sind, die ich auch einmal erwähnen muss:

Das Trackingpad, Touchpad, wie auch immer ihr es nennen wollt. Es reagiert präzise und Klicks werden eigentlich immer akzeptiert. Die Multitouch-Funktionen sind zwar eher eine Softwareangelegenheit, aber sie sind tadellos umgesetzt.

Die Lautsprecher. Nicht, dass ich damit eine Party beschallen wollen würde, aber Sprache und Musik kommen klar, ohne zu klirren, ohne deutlich erkennbare Fehler im Frequenzverlauf. Üblicherweise gebe ich nichts auf Lautsprecher in Laptops, weil sie meist einfach Mist sind. Bei dem Macbook Pro 2015, was ich seit Februar nutze, sind sie ihren Aufgaben komplett gewachsen.

Das Mikrofon. So oft lese ich von miesen Mikros bei Webcams, dass ich tatsächlich sehr angenehm angetan davon bin, dass das Mikro vom Macbook mehr als nur brauchbar ist.

Zu guter Letzt die verbaute Webcam. Ich habe hier ein Sammelsurium an verschiedenen Laptops von Lenovo und Dell sowie auch eine externe Logitech. Alle stinken sie ab gegenüber der Apple-Webcam. Ich dachte, es könne ja nicht so schwer sein, eine gute Webcam nachzukaufen (die Logitech C720 habe ich vor gefühlt 10 Jahren für 30€ gekauft). Pustekuchen. Kleine Kameramodule von sehr brauchbarer Qualität werden zu hunderten Millionen in Smartphones verbaut, aber der Markt für Webcams ist überschwemmt von billigen Chinawebcams und wird dominiert von … Logitech. Besagte C720 ist im Vergleich zur Macbook-Webcams Mist. Bei WMDE haben wir zwei Logitech Meetup in Betrieb genommen, die bei Tageslicht ganz brauchbar sein mögen, aber nur einen digitalen Zoom bieten (für an die 1000€!), wo dann alles recht matschig aussieht. Immerhin 4k, aber so recht hat mich Logitech nicht überzeugt. Aber es gibt kaum andere Anbieter.

Also habe ich mich auf das Abenteuer "unbekannte Hersteller" eingelassen und mir eine "Papalook Webcam HD 1080p" bestellt.

Nach den ersten Tests habe ich sie wieder eingepackt und bei Amazon die Rücksendung beauftragt. Dann stolperte ich über Rezensionen, die der Kamera eigentlich gute Leistung quittierten. Also wieder ausgepackt und an den Parametern gedreht. Und siehe da!: Mein ursprüngliches Problem, dass die Kamera nur 5fps bei Full-HD liefert, lässt sich beheben, wenn ich von der Kamera ein anderes Farbmodell anfordere.

Jetzt waren in OBS die Farben aber immer noch sehr blass und meine Stirn komplett weiß. Aber durch ein bisschen Googeln stieß ich auf einen Artikel, wo die möglichen Parameter (nicht spezifisch Papalook) mal ein wenig erklärt werden. Belichtungskorrektur runter, Helligkeit rauf, Weißabgleich für Kunstlicht einstellen, und das Bild sah gleich deutlich besser aus.

Durch noch ein bisschen mehr Finetuning habe ich dann ein recht ansehnliches Bild bekommen.

Apple, so scheint mir, hat einfach mal sehr gute Voreinstellungen für die technisch immer noch bessere Webcam mitgeliefert. Soll mir recht sein.

Unter Linux muss ich halt ein wenig mehr Hand anlegen. Skeptisch hatte mich gemacht, dass guvcview (Gnome (oder GTK) UVC Viewer (UVC steht für USB Video Class, eine generische Schnittstelle, um Videogeräte per USB zu verbinden)) ein besseres Bild anzeigte als OBS. Und es waren eben besagte Parameter, an denen ich schrauben musste. Jetzt klappt es auch mit dem Chroma-Key und dem Greenscreen.

Die im Laptop verbaute Webcam wirkt auch bei direkter Kontrolle der Bildparameter matschig und als hinge ein Grauschleier davor.

Meine Lehre jedenfalls ist, dass Apple nicht unbedingt überteuerte Hardware anbietet. Sie bieten Hardware an, wo keine Komponente nur mitgeliefert wird, um eine Checkbox auf der Featureliste abzuhaken. Ich persönlich würde mir ja wünschen, dass mehr Hersteller darauf verzichten, Alibi-Hardware zu verbauen.

Übrigens habe ich es auch mit meinem Handy probiert. Aufmerksame Leser*innen wissen ja, dass ich ein Pixel 3a habe, was dank Google mit die beste Bildqualität liefert. Warum nicht deren Bild anzapfen und als Webcam nutzen? Klar doch: IP Webcam installiert und gestartet, Stream in OBS eingebunden … die Qualität war nochmal deutlich besser als die von Apple-Hardware, keine Frage. Bei meinem ersten Versuch schaltete sich das Handy nach einer halben Stunde ab wegen Überhitzung. Das konnte ich beheben, indem ich es ohne Hülle im Stativ betrieb. Das Stativ allerdings klemmte immer irgendwelche Tasten – die Kamera konnte ich damit nicht mittig im Lichtring ausrichten. Kein Beinbruch, nur halt nicht schön. Schlimmer ist, dass die IP-Verbindung zwischen Laptop und Smartphone nicht reibungslos lief. Schon beim zweiten Einsatz ließ sich der Streamserver auf dem Smartphone nicht mehr finden, so dass meine OBS-Konfiguration ins Leere lief. Für mich war das Anlass, mich mal nach guten, externen Webcams umzuschauen. Aber der Markt ist sehr unübersichtlich. Ich muss mir keine Webcam kaufen, die nur marginal besser als die im Laptop verbaute ist. Mit der Neuanschaffung kann ich zumindest wieder halbwegs meinen Spaß an der nächsten Videokonferenz haben.

Was ich mir wünschen würde: Wenn Webcam-Hersteller einfach mal die Kamera-Hardware von zumindest ordentlichen Smartphone-Kameras verbauen würden. Muss ja nicht gleich Huawei-P30-Niveau sein. Ich fürchte aber, ohne die Nachbearbeitung durch die Software liefern auch deren Kameras nur mäßige Ergebnisse. Logitech und Co. liefern ja für Windows (und manchmal auch macOS) Software mit, die das Kamerabild nachbearbeiten. Als Linux-Nutzer stehe ich ohne da und muss selbst Hand anlegen. Spätestens wenn es allerdings um machine learning und KI bei der Bildaufbereitung geht, ist da jedoch bislang Schluss.

Anlass ist übrigens Rollenspiel via Zoom.

"Aber Masin, wenn die Apple-Webcam so toll ist, warum nimmst du dann nicht den Laptop?"

Für mein Privatvergnügen möchte ich nicht Zoom auf meinem Arbeitsgerät installieren, da Zoom in der Vergangenheit durch grobe Patzer gerade unter macOS aufgefallen ist. Immerhin hat die öffentliche Aufmerksamkeit in den vergangenen Monaten dazu geführt, dass Zoom schon kräftig nachgebessert hat. Ich würde gerne auf Zoom verzichten, aber meine Spielrunde hat sich darauf eingeschossen.

Auf Facebook kommentierte dann ein Leser, dass ich ja eine semiprofessionelle Kamera per HDMI einbinden könne.

Auch das war eine Überlegung zwischendurch, eine reguläre Kamera zu benutzen. Da gibt es grundsätzlich ja zwei Ansätze.

Ich erinnere mich, wie ich irgendwann um 2005 herum mal einen Skype-Testanruf bei einem Freund&#160;gemacht habe, ob er mich hören könne. Ging, aber er entschuldigte sich, dass er kein Headset und auch kein Mikro da habe. Merkwürdigerweise hörte ich trotzdem Tastenklappern und Atmen. Stellte sich heraus, dass sein Camcorder, der per Firewire angebunden war, sein Mikro direkt dem Betriebssystem angeboten hat. Bild hatten wir nicht probiert, aber wir waren sehr erstaunt, dass das überhaupt ging.

Der erste Ansatz wäre also, die Kamera per USB anzuschließen und die Signale auf dem Weg abzugreifen. Wir haben hier noch eine alte Kompaktknipse, mit der ich das probiert habe, aber ohne Erfolg. Ich erinnerte mich, dass Darktable zur Steuerung von Digitalkameras genutzt werden kann, und recherchierte mal, wie die das machen und welche Unterstützung es da gibt. Darktable nutzt libgphoto2, und libgphoto2 hat eine sehr praktische Seite der unterstützten Kameras und ihrer Features. Ich kann davon ausgehen, dass ich eine Kamera brauche, wo "Liveview" vermerkt ist. Zwar bieten immer mehr Hersteller Software an, um ihre Kameras als Webcam nutzen zu können, aber die Firmware der Kamera wird das wohl überhaupt anbieten müssen. Ich gehe davon aus, dass das so semi-standardisiert ist und die Liste ziemlich erschöpfend ist. Nur falls jemand eine Entscheidungshilfe braucht.

Vor der neuen Webcam hatte ich billig in einem Sonderangebot eine kleine 4k-Actioncam von Crosstour erworben, eben in der Erwartung, dass da ein Liveview möglich sei (ich wusste zu dem Zeitpunkt noch nix von o.g. Tabelle). Aber die ausgelieferte Firmware hat das Feature nicht mehr, obwohl es noch in der Anleitung steht, glaube ich. Zumindest in Anleitungen, die man online noch herunterladen kann. Es gibt über Umwege eine alternative Firmware, aber sie erlaubt nur HD-Betrieb als Webcam (720p). Sie spannt aber ein Wifi-Netz auf, wo dann das Kamerabild als Stream abzugreifen ist. Das stellt mich nur vor das Problem, gleichzeitig in zwei WLANs zu sein. Für mich ist das nicht praktikabel. HDMI-Anschluss hat sie auch noch – das wäre noch eine Möglichkeit.

Und damit kommen wir zum zweiten Ansatz, den mein Leser auch vorschlug, eben das Kamerabild per HDMI zu capturen. Die dafür notwendige Capturecard habe ich bislang nur so ab 70€ gesehen, empfohlen wird aber wohl Elgatos Camlink ab ca.130€. Ich habe bei Amazon gerade Capture-Sticks ab 14€ gesehen. Für den Preis probiere ích das mal aus. Wahlweise mit der Actioncam oder mit der Kompaktknipse, wobei ich nicht weiß, ob sie HDMI ausspuckt, ich glaube aber schon. Sollte das gehen, würde es meine Optionen zumindest deutlich ausweiten.

Mittlerweile verfolge ich das Vorhaben ja hauptsächlich nur noch aus Spaß an der Freude, nicht um Ergebnisse zu erzielen.

Ich hatte gestern mal wieder meinen Dell-Laptop Latitude E6430 angeworfen und dachte mir, ich schau mir dessen Kamerabild nochmal an. Eigentlich hatte ich ihn deswegen nicht benutzt, weil er doch nicht das stärkste Pferd im Stall ist (Intel Core i5-3230M CPU @ 2.60GHz). Es ist gerade Abend, Katja hat das Licht da angemacht, wo wir üblicherweise unsere Remote-P&P-Runde aussitzen – die Lichtverhältnisse sind vergleichbar.

So schlecht ist die Webcam da tatsächlich nicht, wie ich sie oben beschrieen habe. Vermutlich weil es ein Businessgerät ist.

Ich nutzte die Gelegenheit und habe mal alle anderen verfügbaren und in Frage kommenden Gerätschaften durchgetestet:

Dell Latitude E6430

Apple Macbook Pro 2015

Logitech HD C720

Papalook HD 1080p

Crosstour Actioncam 4k

Leicht andere Perspektive, da ich meinen Platz auf dem Sofa in der Zwischenzeit räumen musste. Für eine 720p-Kamera ist das Bild eigentlich nicht soooo schlecht. Nachteil ist natürlich, dass es sich um eine Fix-Fokus-Kamera handelt, andererseits ist der Fokusbereich groß genug, will ich meinen. Gewöhnungsbedürftig ist der Kisseneffekt wegen Weitwinkellinse.

Lenovo Ideapad Y700

Lenovo Ideapad U330p

Erstaunlich finde ich, dass die Webcam besser ist als die vom Y700, was mehrere Jahre später auf den Markt kam. Trotzdem nur vorletzter Platz in meinem persönlichen Ranking.

Lenovo Thinkpad X230

Von den Lenovo-Laptops zeigt das X230 definitiv die beste Qualität, gleichauf mit dem Macbook, wenn auch mit weniger intensiven Farben.

Google Pixel 3a Frontkamera

Es gibt kein Szenario, in dem diese Kamera zum Einsatz kommen würde fürs gemütliche Rollenspiel per Videokonferenz. Sie ist nur der Vollständigkeit halber aufgeführt. Man beachte, dass sie besser ist als praktisch jede integrierte Laptop-Webcam in einem Smartphone, dass bei Markteinführung für 400€ über den Ladentisch ging.

Google Pixel 3a Hauptkamera

Ohne Blick auf den Monitor ist es ganz schön schwer, sich selbst zu knipsen. Hat für den ersten Versuch aber ganz ordentlich funktioniert. Ich denke, die Bildqualität spricht für sich, warum ich versucht habe, sie als Webcam einzuspannen.

Lenovo Tab4 10plus

Hier sieht man, dass Lenovo nicht nur schlechte Kameras verbaut. Sie ist vielleicht nicht wirklich gut, aber im Vergleich zu den Laptop-Webcams ein echter Augenöffner. Die Teilnahme an der Videokonferenz mit dem Tablet ist aber eher unkomfortabel für zwei Personen. Dafür ist das Display dann doch zu klein. Außerdem lässt sich das Tablet in seiner Hülle nur begrenzt ausrichten.

Apple iPhone 8 Frontkamera

Apple iPhone 8 Hauptkamera

Sony Playstation Eye

Die Kamera ist alt. Sie meldet sich ja nicht mal als UVC-Gerät und braucht ein eigenes Kernelmodul. Aber sie schafft hohe Bildraten (60 Hertz).

Mir ist noch zusätzlich ein Thinkpad in die Hände gefallen, das ich heute Abend mal testen kann, wenn die Lichtverhältnisse wieder vergleichbar sind. Außerdem habe ich ja noch mein Arbeits-iPhone, das ich zwar nie dafür verwenden würde, aber welches ich durchaus der Vollständigkeit einmal mit aufführen kann. Meine alten Nexusse (Nexen? Nexi?) und das Oneplus One werde ich mir aber ersparen.

Der billige USB-HDMI-Capture-Stick kommt heute. Ich mache mich dann mal auf die Suche nach dem Ladegerät. Die Beispielbilder werde ich oben nachreichen, weitere Gedanken hänge ich ggf. als Update markiert ans Ende des Beitrags.

Update 2020-10-29 19:00 Uhr

Mit dem Bild des Thinkpads würde ich ja sagen, die Grenze zwischen grottigen und akzeptablen Webcams verläuft zwischen Consumer- und Business-Geräten, wie auch bei vielen anderen Merkmalen. Die Erweiterbarkeit und Reparierbarkeit von Consumer-Geräten ist gegenüber Business-Geräten immer nachrangig. Die Bildschirme von Business-Geräten sind für längere Arbeitszeiten vorgesehen und nicht für den schnellen Reiz bei der Ausstellung in der Computerabteilung. Ich könnte mir noch die Mühe machen und mein HP-Compaq-Netbook aus der Schublade holen, aber allein die Vorstellung, den Bootvorgang zu durchstehen bereitet mir körperliche Schmerzen – ich gehe mal davon aus, dass die Webcam darin nur dem Haken auf der Featureliste diente.

Eigentlich punkten Consumer-Geräte nur bei einem Punkt: dem Preis. Gerne in Verbindung mit vermeintlich in harten Zahlen ausgedrückten Merkmalen wie Takt oder Massenspeicher. Ich rate schon seit Jahren dazu, lieber ein gebrauchtes Business-Gerät letzter oder vorletzter Generation zu kaufen statt eines neuen Consumer-Geräts. Viele nicht so offensichtliche Merkmale machen deren Benutzung und Besitz um einiges angenehmer.

Ich will nicht verschweigen, das gebrauchte Business-Geräte womöglich doch den einen oder anderen Nachteil haben dürften. So werden sie wahrscheinlich dicker oder schwerer sein, der Akku wird Alterungsspuren aufweisen, und überhaupt kann eine CPU der letzten oder vorletzten Generation und ihre dazugehörige Hardware stromhungriger sein.

Pflichtdienst im Gesundheitswesen

Ich bin kein ausgewiesener Experte, kein Politiker oder Jurist. Nur interessierter Laie.

In den vergangenen Wochen seit Ausbruch der Pandemie ist klargeworden, dass zu Schönwetterzeiten Kapazitäten zur Krisenbewältigung nicht vorgehalten werden, weil sie große Kosten verursachen. Erst heute habe ich gelesen, dass die Experten vom Robert-Koch-Institut die heutige Situation für die Regierung wie in einem Drehbuch beschrieben hätten:

2013 wurde dem Bundestag eine Risikoanalyse des Robert Koch-Instituts für gerade dieses Szenario vorgestellt. Dass sich die Risikoanalyse vom 10.12.2012 nicht einmal acht Jahre später wie ein Drehbuch dessen liest, das wir gerade durchleben, kann man als blanke Ironie ansehen, wenn man bedenkt, dass die Bundesregierung diesen Bericht ersichtlich nicht zum Anlass genommen hat, entsprechende Vorkehrungen zu treffen. Im Hinblick darauf wird man zur gegebenen Zeit fragen müssen, ob wir hier Zeug*innen eines beispiellosen Versagens geworden sind und wie wir das in Zukunft vermeiden können.

Nun ist es ja nicht so, dass das das erste Mal gewesen wäre, dass Krisen vorhergesehen wurden. Ich erinnere mich daran, dass seit 2011 oder 2012 vor einer großen Flüchtlingsbewegung nach Europe gewarnt worden wäre, auf die Europa nicht vorbereitet sei. Man hatte also mehrere Jahre, um Kapazitäten an Flüchtlingsunterkünften aufzubauen oder vor Ort zu helfen, bevor 2015 das Szenario tatsächlich eintrat.

Jetzt ist es so, dass es zumindest einen Bereich gibt, wo Kapazitäten vorgehalten werden, ohne dass sie akut benötigt würden: beim Militär. Ca. 25 Milliarden Euro jährlich bezahlen wir gemeinschaftlich, um uns ein Militär zu finanzieren, das seiner Aufgabe der Landesverteidigung wohl nie nachkommen wird. Warum hier mit zweierlei Maß gemessen wird, kann ich nur vermuten, aber neben historischen Gründen kann ich mir auch vorstellen, dass ein stehendes Heer gewisse patriarchalische Neigungen befriedigt, die ein ausreichend großes Gesundheitssystem oder Kapazitäten zur humanitären Hilfe nicht befriedigen können.

Aber vielleicht lässt sich vom Militär ja was für den Krisenfall lernen. Ich denke da an den guten alten Wehrdienst. Im Moment scheint ja eines der Probleme der schnellen Aufstockung an Intensivpflegebetten zu sein, dass gar nicht ausreichend Personal da sei. Vielleicht ließe sich dem abhelfen, wenn es eine Art Pflichtdienst im Gesundheitswesen für alle Schulabgänger gebe, 12 Monate nach der Schule oder Ausbildung. Dazu Pflegekraft auf Zeit für 4, 8 oder 12 Jahre (PaZ4, PaZ8, PaZ12). Und natürlich Berufspflegekräfte. Dazu eine Pflegekraftreserve, die im Krisenfall "einberufen" werden kann.

Das bringt natürlich nichts, wenn man 10 Jahre nach dem eigenen Dienst einberufen wird, man hat ja alles vergessen – es braucht regelmäßige Auffrischungen, z.B. jedes Jahr zwei Wochen oder alle 4 Jahre ein Monat. Das hilft auch, mit dem Stand der Technik halbwegs vertraut zu sein.

Ich gebe es offen zu: Ich habe meinen Pflichtdienst nicht leiden können. Rückblickend war es eine lehrreiche Zeit, aber ein Einschnitt in meine Planungen war es auch. Und ich sehe auch nicht, dass der Zeitgeist eine solche Maßnahme unterstützen würde – zu groß sind heute wohl die Widerstände gegen solche Einschnitte in die selbstbestimmte Berufs- und Lebensplanung. Aber es wurde in der Diskussion um Kontakt- und Ausgangssperren nach Alternativen gefragt. Und wenn das Gesundheitssystem flexibel auf die Erfordernisse reagieren könnte, müssten solche Diskussionen nicht geführt werden. Dafür würden halt Einschnitte an anderer Stelle stattfinden. Und darüber müsste diskutiert werden.